トピックス 2019.05.10 AIだって騙される?AIの抱える弱点とは一体何か

SiriやGoogleアシスタントといったスマートフォンの音声アシスタント機能やルンバなどのお掃除ロボットなどAI(人工知能)を取り入れたサービスは既に私たちの身近なところで普及し始めています。

将来的には自動運転や医療診療といったようにさらなる活用が期待されるAIですが、AIの開発が進むに連れてAIの持つ弱点や脆弱性にも注意を向けなければいけないことが分かってきました。

今回は現在発見されているAIの脆弱性についていくつかの事例を取り上げながら、万能かのように思われているAIが今後発展していくために乗り越えなければいけない課題について紹介します。

AIがパンダとテナガザルを混同?!

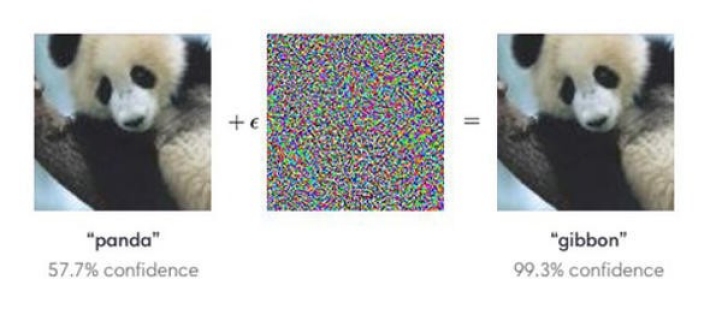

アメリカでAIの研究を行なっている非営利団体の「Open AI」は、元々ある画像データにモザイクのようなノイズデータを加えることでAIの画像認識を簡単に狂わせてしまう方法を発見しました。

Open AIでは、パンダの画像に特定のノイズを加えることで、AIはパンダの画像をテナガザル(gibbon)の画像と誤認識してしまうケースを紹介しています。

▲パンダの画像にノイズデータを加えると、テナガザル(gibbon)と誤認識してしまう(出展:OpenAI)

こうした人が見れば一目瞭然でも、AIはそれを誤認識をしてしまうというAIの弱点を突いた攻撃は「アドバーサリアル・エグザンプルズ(敵対的サンプル)」と呼ばれ、大きな議論を呼んでいます。

自動運転における標識や人の誤認リスクも

AIの画像認識における脆弱性は、悪用されると将来自動運転が実用化された時に「一時停止」や「進め」といった標識を悪意のある人物の攻撃によって誤認識させられてしまう可能性も考えられるようです。

実際にミシガン大学やワシントン大学の研究チームが2017年に行った実験では、道路にある交通標識に白と黒のステッカーを貼り付けることで「止まれ」の標識を「制限時速45マイル(72キロ)」とAIに誤認識させることができたと発表しました。

同様に、AIが車外の状況を画像として認識する際、実際には横断歩道を渡っている人がいてもAIには誰も人が存在しないように思わせる方法も確認されていて、こうした脆弱性への今後の対策が注目されています。

人には聞こえない超音波でAIを操作することができる?

AIの弱点はどうやら画像認識だけでなく音声認識にも存在するようです。

「Siri」や「Google Home」など音声で呼びかけることによって起動するAIを使ったアシスタント機能がありますが、人間には聞こえない周波数で音声アシスタントを操作できる「ドルフィンアタック」と呼ばれる手法が存在します。

中国・浙江大学の研究によれば、人間には聞こえない音声コマンドを送ることでiPhoneから特定の電話番号へ電話をかけたり、MacBookやAndroidのスマートフォンから悪質なソフトウェアが埋め込まれているウェブサイトへアクセスさせることも可能であるのだそうです。

現時点ではこの「ドルフィンアタック」は音声アシスタント機器から1メートルの範囲内程度でないと機能せず遠く離れた場所からこっそりと操作できるほどの性能ではないことが分かっていますが、各メーカーには対応が求められています。

AIが発展していくための課題とは?

膨大な計算を高速で行うなどAIにはとてもスマートな一面がある一方で、悪意のある攻撃に対して脆弱な部分があるのもまた事実です。

ここで今後AIが弱点を克服し、さらに発展していくためのキーポイントと言われている項目を紹介します。

優良なデータの取得

コンピューターサイエンスの世界では無意味なデータを入力すると無意味な結果が返されるとして「Garbage in, Garbage out.(ガラクタを入れればガラクタが出てくる)」という言葉がありますが、これはAIの研究においても全く同じことが当てはまります。

AIが学習を行う際のデータを慎重に選んでインプットするだけでなく、サンプルとなるデータの適切な分類や特徴の偏りを補正する方法などにも注意が必要です。

また、パンダの画像をテナガザルと誤認識させた「アドバーサリアル・エグザンプルズ(敵対的サンプル)」に対しても、その攻撃の手法やパターンをあらかじめ学習しておくことである程度の備えを行なっておくことができると考えられています。

AIが判断を誤ることへの備え

AIが学習を行う過程ではいくつかのケースで誤った認識をしてしまうことは避けられず、そうした間違いを繰り返すことによって判断の精度を高めています。

しかし、実際にAIを活用するシーンでは100回に1回の判断ミスも許されないような高度な要求がAIに対してされる場面も想定されるため、AIによる誤検出をどれだけ減らせるかということは大きなポイントの1つになります。

環境の変化への対応

また、AIの特徴として環境変化に弱い点が挙げられます。AIの基本的な仕組みは、大量のデータを学習してその中から規則性を見出すことにあるため、学習を行なった範囲に対しては人間以上のスピードと精度で判断することができても、学習を行なっていない未知の領域に対しては新しく学習しなければいけません。

例えばサイバーセキュリティの場合に、攻撃を行う側が全く新しい手法を生み出した場合、例えAIであっても即座に対応が行えるわけではないので、どれだけ対処にかかる時間を減らすことができるのか注目されています。

まとめ

今回紹介したようなAIの弱点は重要な課題として大きな注目を集めている中、1つ指摘されていることは、AIが私たち人間に比べて神経質すぎるのではないかという点です。

もちろん、高度な認識能力を持ったAIが細部の情報まで詳細に分析を行うのは自然なことではありますが、AIもヒトと同じようにある程度鈍感になる必要があるかもしれません。

「優秀なAIを鈍感にさせる」というのはかなり難しいようにも思われますが、今後の研究に期待がかかります。

【関連リンク】

・AIとセキュリティ ーAIは安全か?ー(みずほ情報総研)

https://www.mizuho-ir.co.jp/publication/column/2018/0529.html

・Attacking Machine Learning with Adversarial Examples(Open AI)

https://openai.com/blog/adversarial-example-research/

・Robust Physical-World Attacks on Deep Learning Models(arXiv)

https://arxiv.org/abs/1707.08945

・DolphinAttack: Inaudible Voice Commands - Dolphinattack.pdf(PDF)

https://assets.documentcloud.org/documents/3987864/Dolphinattack.pdf

TEXT:セキュリティ通信 編集部

PHOTO:iStock

- tag